- A+

爬网预算是一个经常被误解的概念,通常在搜索引擎优化和数字营销社区讨论。

大多数人倾向于认为这是某种神奇的东西,你可以用它来“黑客”你的方式,谷歌的最高结果。

尽管所有的内容都是关于搜索引擎是如何工作的,尤其是爬行的过程,但市场营销人员和网站管理员似乎仍然对爬网预算的概念感到困惑。

问题

对于搜索引擎的基本原理和搜索过程是如何工作的,人们显然缺乏了解。

这种现象会造成混乱,通常会导致商人所说的“闪亮物体综合症”,这基本上意味着如果不了解基本原理,营销人员的辨别能力就会下降,因此他们会盲目地听从任何人的建议

解决方案

本文将教你爬行的基本原理,以及如何使用它们来确定“爬网预算”是否是你应该关心的,以及它是否真的对你的业务/网站很重要。

您将学习以下内容:

- 搜索引擎的工作原理(简介)

- 爬行是怎么工作的

- 什么是爬网预算,它是如何运作的

- 如何跟踪和优化它

- 爬行的未来

我们开始吧。

定义

在我们深入研究爬行预算的概念及其含义之前,了解爬行过程是如何工作的以及它对搜索引擎意味着什么是很重要的。

搜索引擎的工作原理

根据谷歌的说法,搜索引擎从网页中生成结果有三个基本步骤:

- 爬网:网络爬虫访问公共可用的网页

- 索引:谷歌分析每个页面的内容并存储找到的信息

- 服务(和排名):当用户输入一个查询时,谷歌会从其索引中显示最相关的答案

没有抓取你的内容将不会被索引,因此它不会出现在谷歌。

爬行过程的细节

谷歌在其关于爬行和索引的文档中指出:

“爬网过程从一系列网址开始,爬虫程序使用这些网站上的链接来发现其他网页。该软件特别关注新网站,现有网站的变化和死链接。计算机程序确定要爬网的站点、从每个站点获取的页面的频率和数量。“

这对搜索引擎优化意味着什么,

- 爬虫程序使用站点上的链接来发现其他页面。(网站的内部链接结构至关重要。)

- 爬虫程序优先考虑新站点、现有站点的更改和死链接

- 一个自动化的过程决定了哪些站点需要爬网,多久一次,以及Google将获取多少页面

- 爬网过程受托管能力(服务器资源和带宽)的影响

正如你所看到的,考虑到网络的规模,对搜索引擎来说,爬网是一个复杂而昂贵的过程。

如果没有一个有效的爬行过程,谷歌将无法“组织世界上的信息,并使其普及和有用”

但是,谷歌如何保证有效的爬行,

通过优先考虑页面和资源。

对谷歌来说,几乎不可能,而且成本高昂。

现在我们了解了爬行过程的工作原理,让我们更深入地了解爬行预算的概念。

什么是爬网预算

爬网预算是爬网程序设置在某一时间段内爬网的页数。

一旦你的预算用完,网络爬虫将停止访问你的网站内容,并转移到其他网站。

每个网站的爬网预算是不同的,你的网站的爬网预算是由谷歌自动建立的。

搜索引擎使用各种各样的因素来确定你的站点分配了多少预算。

一般来说,谷歌在分配爬网预算时使用的四个主要因素是:

- 站点大小:较大的站点需要更多的爬网预算

- 服务器设置:站点的性能和加载时间可能会影响分配给它的预算

- 更新频率:你多久更新一次内容,谷歌将优先考虑定期更新的内容

- 链接:内部链接结构和死链接

虽然爬行相关的问题确实会阻止Google访问站点最关键的内容,但重要的是要了解爬网频率是一个质量指标而不是。

让你的网站更频繁的爬网并不能帮助你更好的排名。如果你的内容达不到观众的标准,它就不会吸引新用户。这是不会改变谷歌机器人爬行你的网站更频繁。

(虽然爬行对于进入结果是必要的,但它不是排名信号。)

爬行预算是如何运作的

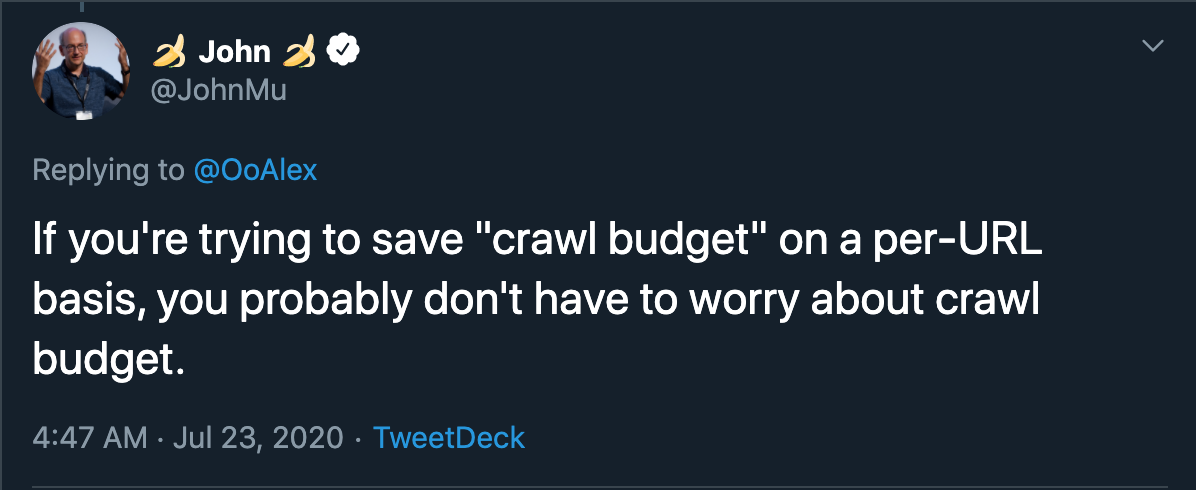

关于爬网预算是如何运作的,我们所掌握的大部分信息都来自谷歌网站管理员中心博客加里·伊利斯的一篇文章。

在这篇文章中,Illyes强调:

- 爬网预算不应该是大多数出版商必须担心的事情

- 如果一个站点的url少于几千个,大多数时候它都会被高效地爬网

为了更好地理解爬网预算,您需要了解以下关键概念。

爬网速率限制

谷歌知道,如果不小心,它的机器人会对网站施加严重的限制,因此他们有控制机制,以保证他们的爬虫程序只访问一个网站,只要是该网站的可持续性。

爬网速率限制可以帮助谷歌确定网站的爬网预算。

下面是它的工作原理

- 谷歌机器人会抓取一个网站

- 机器人将推送站点的服务器,并查看它如何响应

- 然后Googlebot会降低或提高这个限制

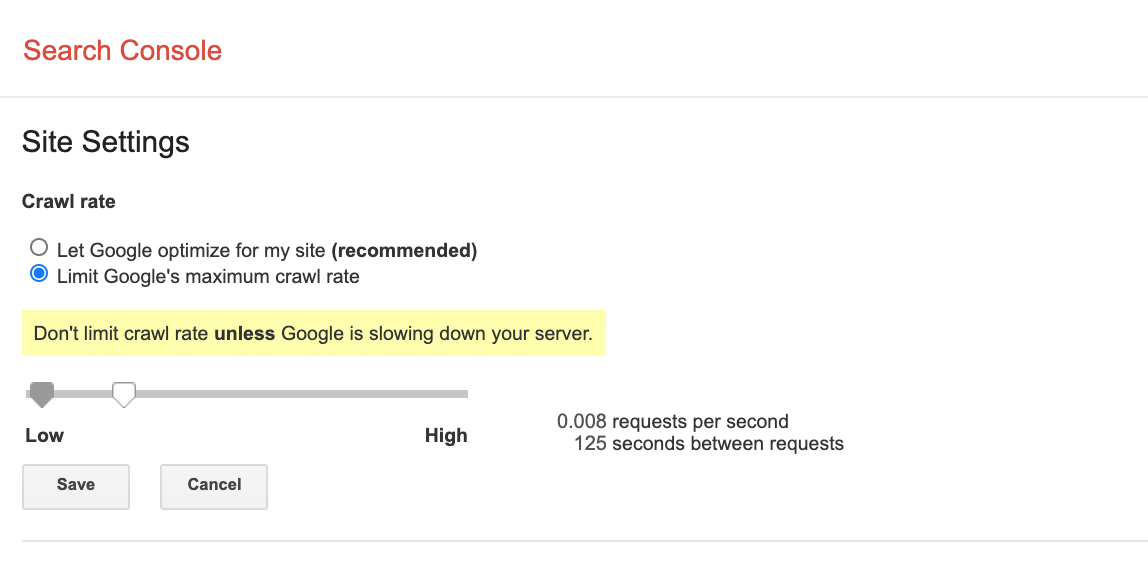

英文网站优化网站所有者也可以在Google搜索控制台中通过打开您的属性的爬网率设置页面来更改限制。

爬网需求

Googlebot还考虑了任何特定URL从索引本身获得的需求,以确定它应该是主动的还是被动的。

决定爬网需求的两个重要因素是:

- URL流行度:热门页面将比不常用的页面更频繁地被编入索引

- 过时:谷歌的系统将防止过时的网址,并将有利于最新的内容

Google主要使用这些爬网速率限制和爬网需求来确定Googlebot可以和想要爬网的url数量(爬网预算)。

影响爬网预算的因素

在你的站点上有大量的低值url会对站点的爬网能力产生负面影响。

像无限滚动、重复内容和垃圾邮件这样的事情将大大降低网站的爬行潜力。

以下是影响网站爬网预算的关键因素列表。

服务器和宿主安装程序

谷歌考虑每个网站的稳定性。

Googlebot不会持续爬网一个不断崩溃的网站。

分面导航和会话标识符

如果你的网站有很多动态页面,它可能会导致动态url和可访问性问题。

这些问题将阻止谷歌在你的网站上索引更多的页面。

重复的内容

复制可能是一个大问题,因为它不能为谷歌用户提供价值。

低质量内容和垃圾邮件

爬虫也会降低你的预算,如果它看到你的网站上有很大一部分内容是低质量或垃圾邮件。

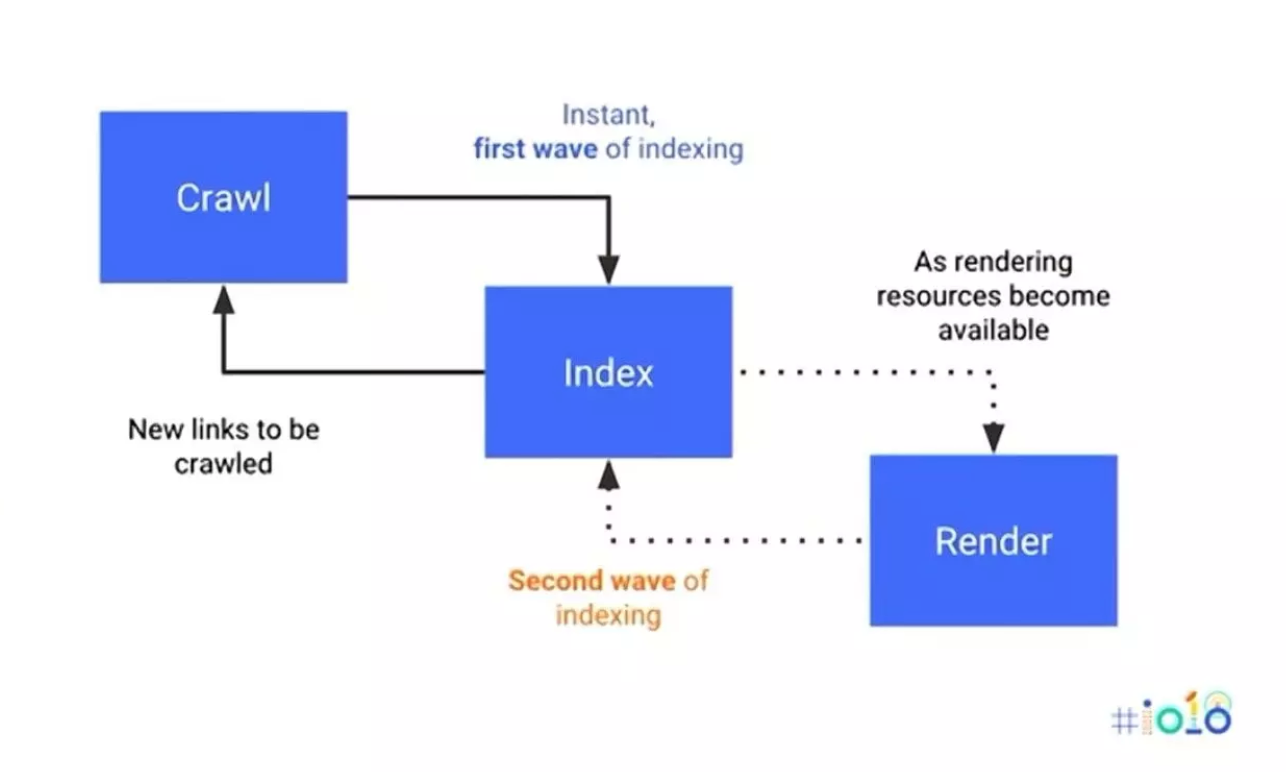

渲染

渲染期间提出的网络请求可能会计入爬网预算。

不确定渲染是什么,

它是用来自api和/或数据库的数据填充页面的过程。

它有助于谷歌更好地了解你的网站的布局和/或结构。

如何跟踪爬网预算

由于新的搜索控制台隐藏了大多数遗留报告,因此很难计算和监视当前的爬网预算。

另外,对于很多人来说,服务器日志的概念听起来非常技术化

以下是两种常用的监控爬网预算的方法。

谷歌搜索控制台

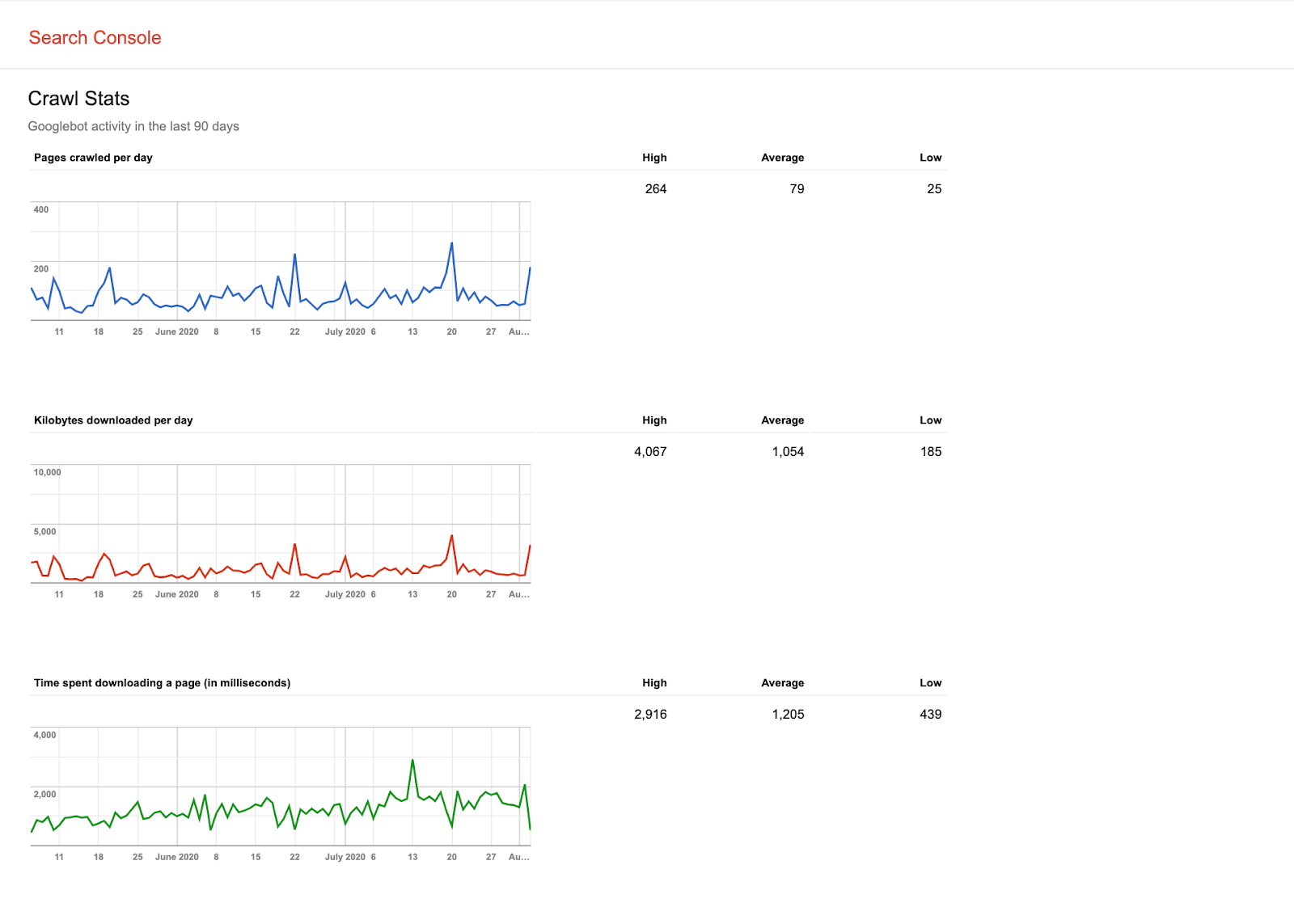

步骤1:转到搜索控制台>传统工具和报告>爬网统计

第2步:访问Crawl Stats报告,了解Googlebot过去90天的活动情况。(你能看到任何图案吗?)

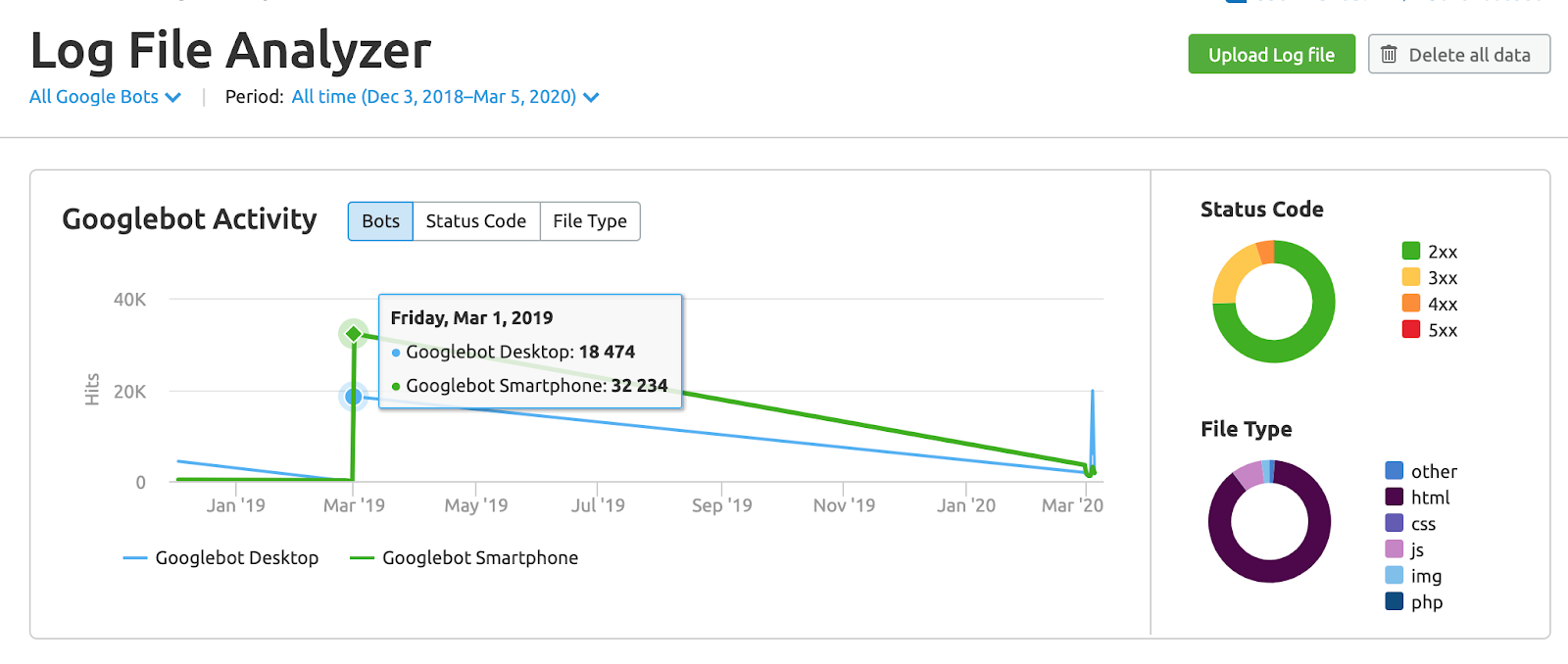

服务器日志

服务器日志存储对Web服务器的每个请求。

每次用户或Googlebot访问您的站点时,都会将一个日志条目添加到访问日志文件中。

当Googlebot访问你的网站时,它会在你的访问日志文件中留下一个条目。

您可以手动或自动分析此日志文件,以查看Googlebot访问您的网站的频率。

有商业日志分析器可以做到这一点,他们帮助你获得谷歌机器人在你的网站上做什么的相关信息。

服务器日志分析报告将显示:

- 你的网站被爬网的频率

- 哪些页面是Googlebot访问最多的

- bot遇到的错误类型

下面是最流行的日志分析工具列表。

SEMrush日志文件分析器

搜索引擎优化日志文件分析器由尖叫蛙

OnCrawl日志分析仪

黑特公司的Botlogs

SEOlyzer公司

如何优化爬网预算

到目前为止,我希望你知道优化爬网预算是更重要的大型网站。

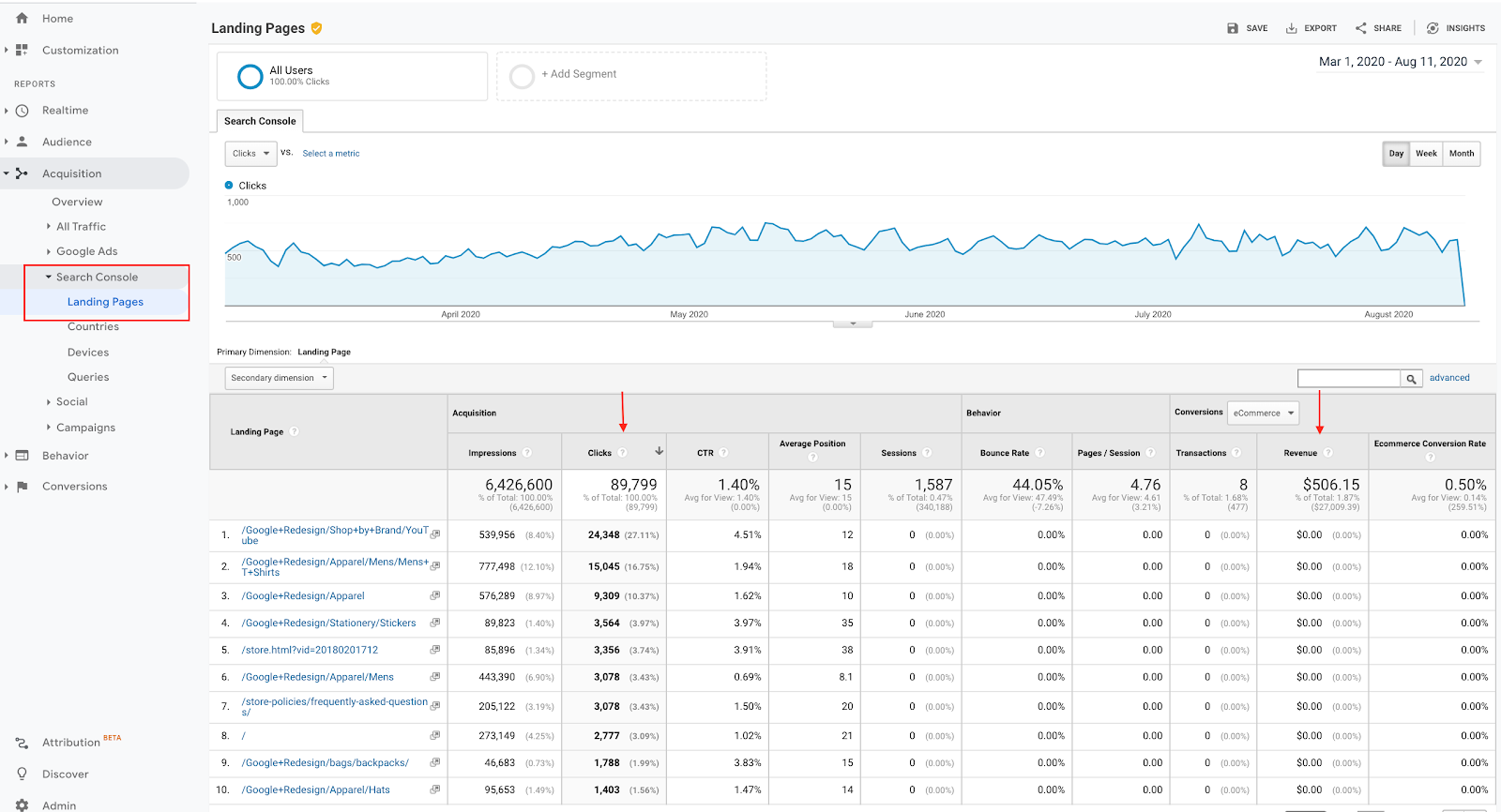

1、优先考虑爬网的内容和时间

你应该总是优先考虑那些为你的最终用户提供真正价值的页面。

下面是如何通过整合来自Google分析和搜索控制台的数据来找到这些url。

网页产生点击和收入应该很容易为爬虫访问。

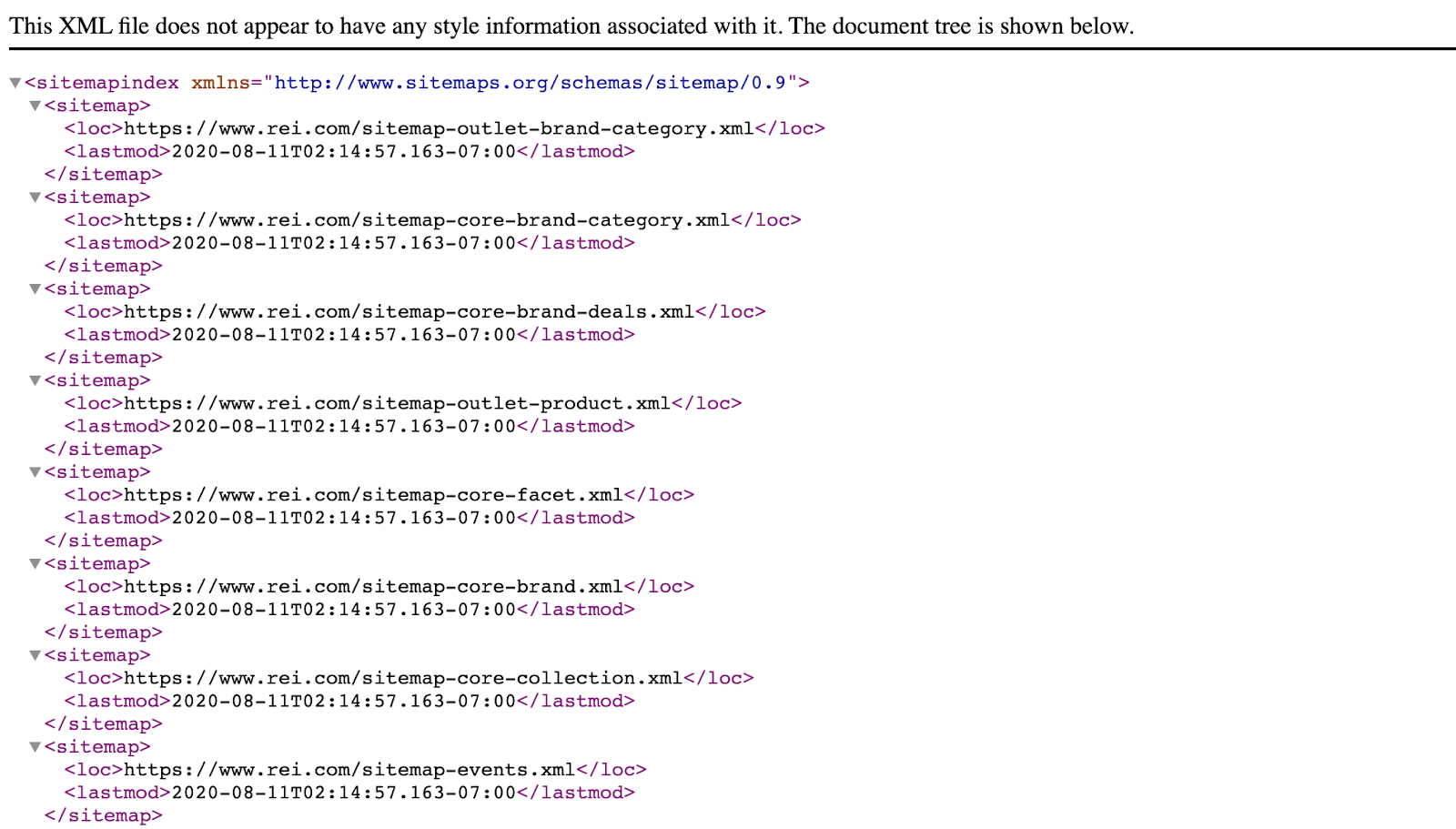

有时,创建一个单独的XML站点地图(包括或您的关键页面)是一个好主意(稍后将详细介绍)

2、确定承载站点的服务器可以分配多少资源

下载服务器日志文件并使用上面提到的工具之一来识别模式和潜在问题

下面是SEMrush日志文件分析器的一个示例

您的最终目标应该是了解Googlebot对当前服务器设置的影响。

3、优化页面

XML站点地图优化

在你的站点中创建多个按URL类型或部分分类的站点地图(例如。,产品.xml,博客-邮政编码.xml等等)。

这将帮助您控制对站点上最有价值的部分的爬网过程。

更新频率

确保每次更新内容时都通知谷歌。

您可以通过英文网站优化结构化数据、XML站点地图甚至eTag来实现这一点。

低质量内容、垃圾邮件和重复内容

通过删除低质量、重复内容和/或垃圾邮件来清理网站。

链接问题

从一页到另一页的链接对于爬行过程仍然非常重要,

每个网站都应该定期修复错误的重定向、404错误和重定向链。

在机器人.txt优化

你可以优化你的机器人.txt通过从爬网过程中排除无价值的URL或文件(如内部分析或聊天机器人程序)来创建文件。

不要从Googlebot中排除有用或重要的源代码(即呈现特定页面所需的CSS文件)。

爬行过程是如何改变的

谷歌和爬网过程都是随着时间的推移而发展的。

以下是我们在过去几年中经历的最重要变化的概述。

移动优先索引

2018年3月,谷歌开始优先考虑整个网络的移动内容,并将其索引从桌面优先更新为移动先行,试图改善用户在移动设备上的体验。

随着这一转变,谷歌的桌面机器人被智能手机Googlebot取代,成为主要的爬虫程序。

谷歌最初宣布,从2020年9月开始,所有网站将改用移动第一索引。

由于一些问题,这一日期被推迟到2021年3月。

当切换完成后,大部分搜索爬行将由谷歌的移动智能手机用户代理完成。

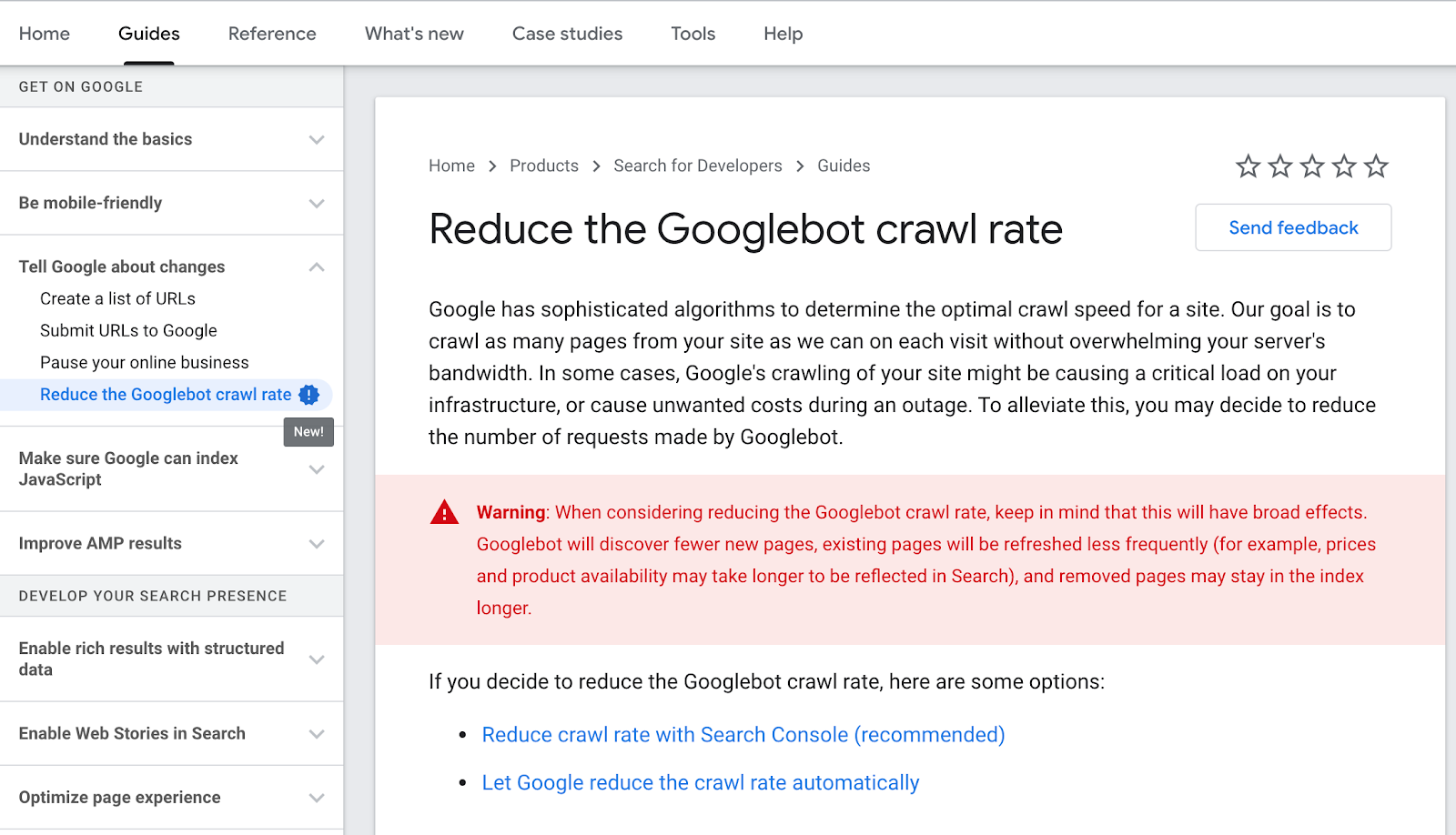

降低Googlebot的爬行速度

对于在爬网过程中遇到严重服务器问题或不必要成本的网站,谷歌允许降低爬网率。

他们的开发者文档有一个新的指南。

爬行的未来

正如kevinindig指出的,有迹象表明,Google访问web内容的方式有可能从爬行转向索引api。

从移动优先到人工智能优先

2017年,谷歌CEO Sundar Pichai宣布从搜索和组织世界信息向人工智能和机器学习过渡。

这种转变将在所有产品和平台上实施

Google搜索已经在使用不同类型的机器学习(即BERT)来支持和提高对人类语言、排名算法和搜索结果页面的理解。

对机器学习和人工智能程序的大量投资将使谷歌能够为高度个性化的搜索结果页面获得更好的预测模型。

(请注意,谷歌人工智能开发的大多数应用程序都是纯机器学习应用程序和狭义人工智能。)

有了一个能够基于多个数据点(即位置、搜索历史、实体喜好等)对网站进行排名的精确预测模型,当前的爬行过程将变得多余,因为搜索引擎将能够以有限的输入提供良好的输出。

换句话说,谷歌不需要搜索整个网络,只需要为用户搜索相关网站。

谷歌已经在对此进行测试。

在一篇名为《商业网络内容预测性爬行》(Predictive Crawling for Commercial Web Content)的论文中,你可以看到他们是如何创建一个机器学习系统的,该系统能够通过预测谷歌购物电子商务网站的价格变化来优化爬行来源。

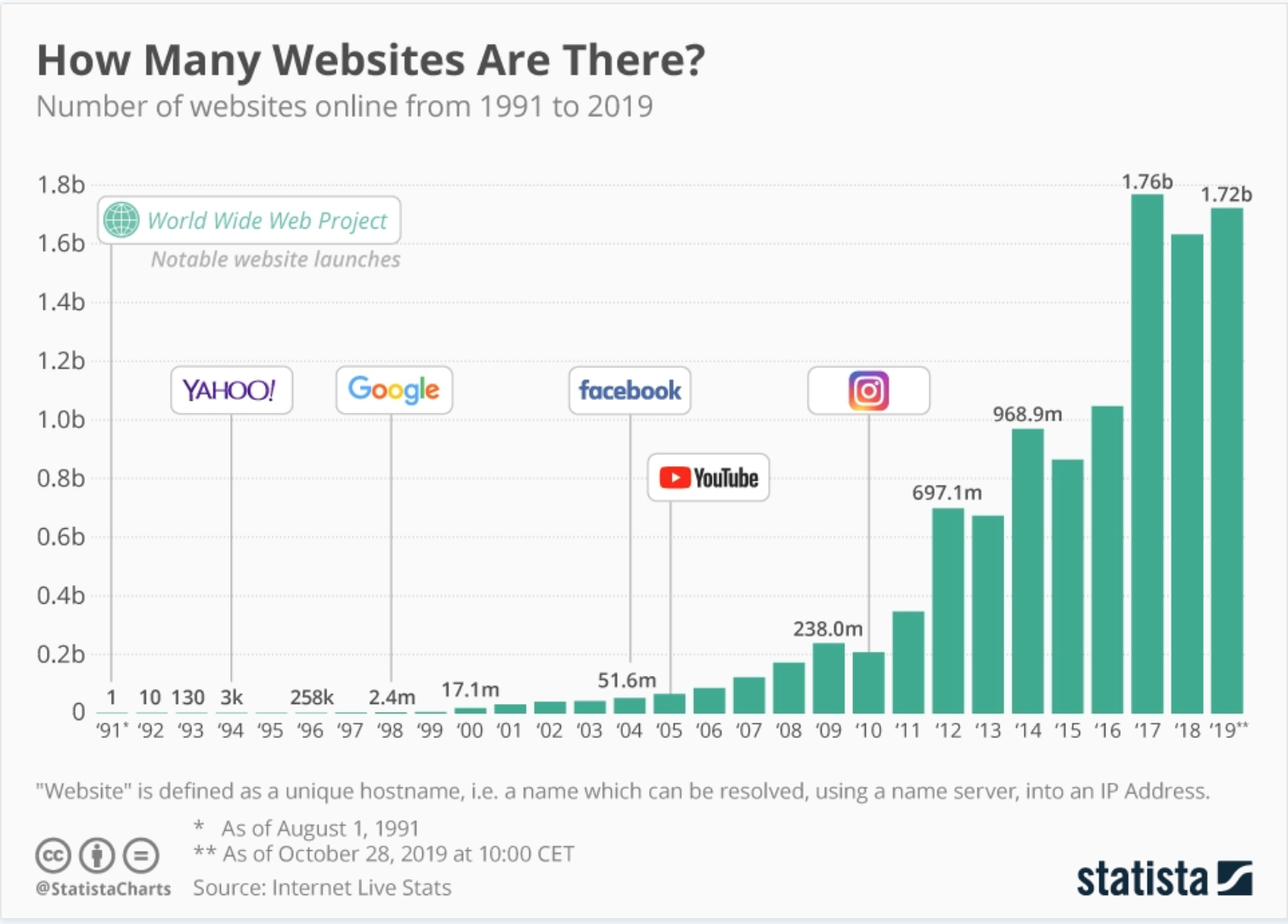

网络越爬越难

随着互联网上近20亿个网站的出现,对谷歌来说,对内容进行抓取和索引已经成为一个具有挑战性且成本高昂的过程。

如果网络继续以这种速度增长,谷歌将更容易控制搜索的索引和排名过程。

在不浪费资源的情况下拒绝垃圾或低质量的网页谷歌将大大改善其运营。

在未来,谷歌可能需要缩小其索引的大小,以优先考虑质量,并确保其结果是相关的和有用的。

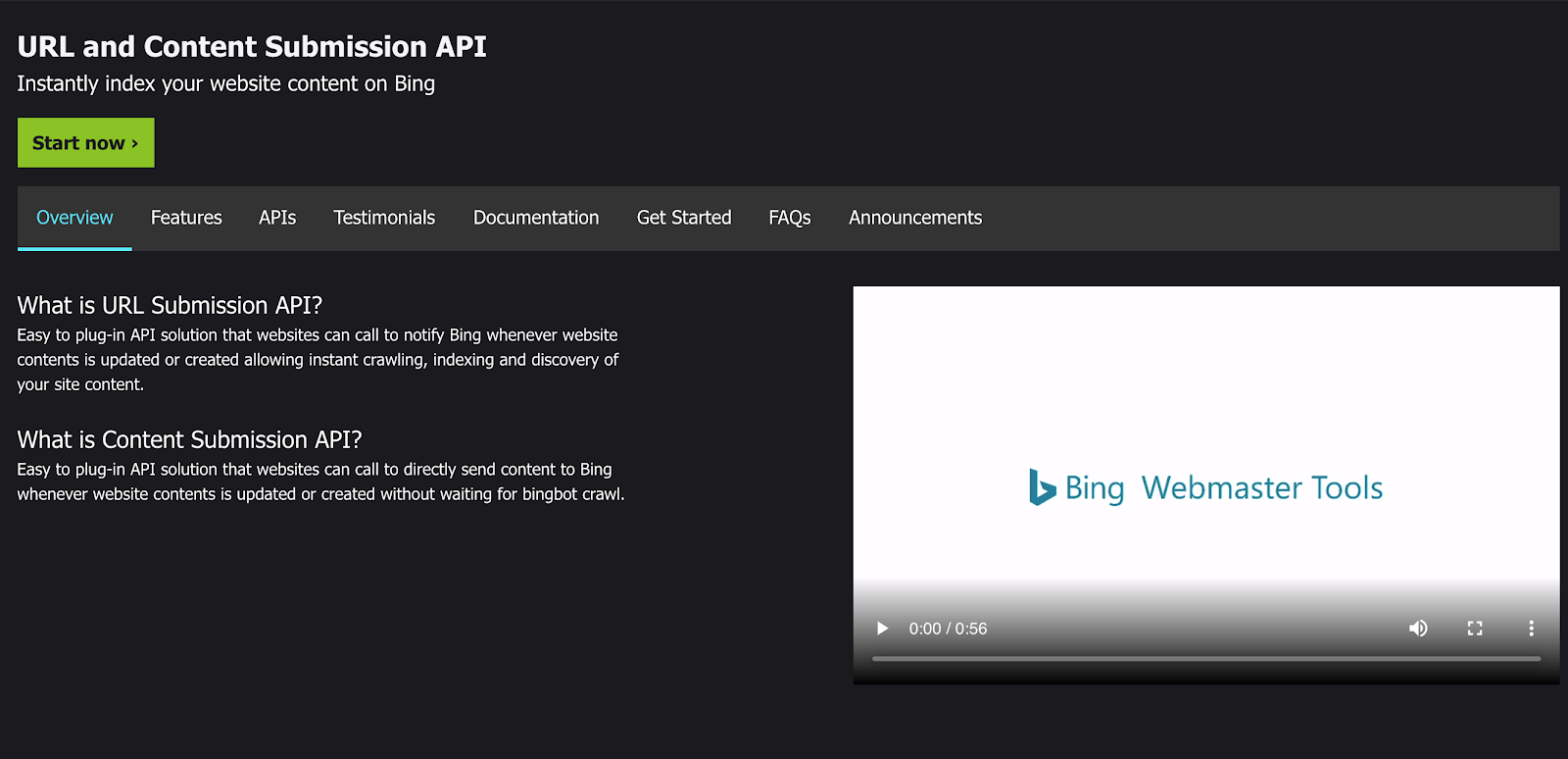

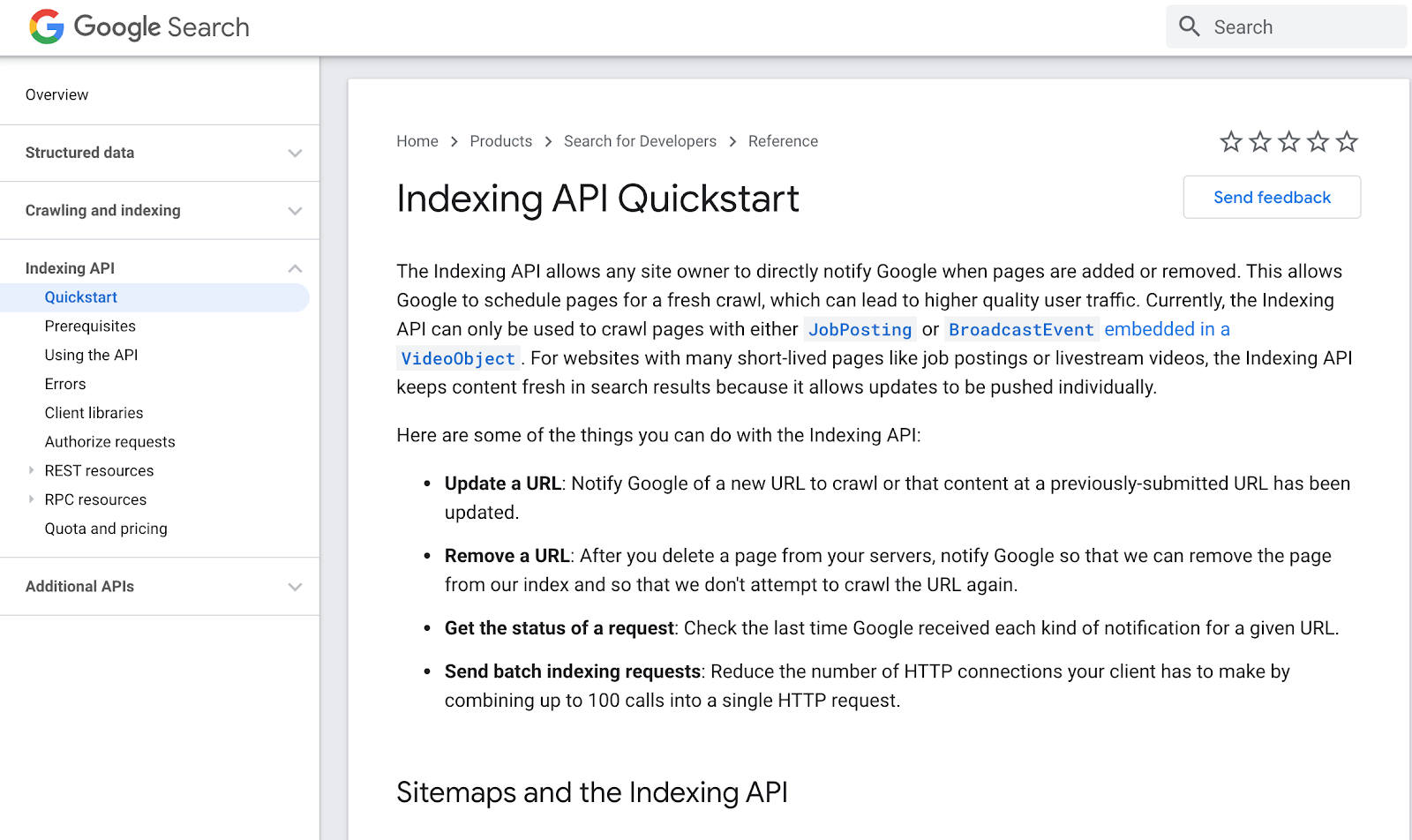

谷歌和必应都有索引API

这两家公司都开发了工具,你可以在网站更新时通知他们。

索引API旨在提供对站点内容的即时爬网、索引和发现。

结束语

爬网预算-作为一个概念和潜在的优化指标-是相关的和有用的特定类型的网站。

在不久的将来,随着谷歌不断地为用户开发和测试新的解决方案,爬行预算的想法可能会改变甚至消失。

坚持基本原则,优先考虑为最终用户创造价值的活动。

森摩尔网络从2013年开始做外贸网站的SEO推广服务,到现在已经7年多了。我们已经为上千个人和企业提供外贸网站的优化推广服务,客户遍及全国各地,我们的服务深受客户好评!如果您有外贸网站需要推广,请联系我们,我们会提供专业、快速的额服务!